Google Cloud Next ‘23 เปิดตัวโครงสร้างพื้นฐานและโมเดล AI

สำหรับธุรกิจในเอเชียตะวันออกเฉียงใต้ เพื่อสร้างแอปพลิเคชัน Gen AI ระดับองค์กร

ในงาน Google Cloud Next ‘23 ที่ผ่านมา Google Cloud ได้ประกาศความร่วมมือและชุดนวัตกรรมผลิตภัณฑ์ใหม่ เพื่อช่วยให้ธุรกิจองค์กรและภาครัฐในเอเชียตะวันออกเฉียงใต้สามารถทดลองใช้และสร้างแผนงานต่าง ๆ ด้วยโมเดลภาษาขนาดใหญ่ (LLM) และโมเดล generative AI (gen AI) ได้อย่างง่ายดาย รวมถึงยังสามารถเลือกใช้ ผสมผสานและปรับแต่งเครื่องมือต่าง ๆ ลงในแอปพลิเคชันได้อย่างราบรื่นด้วยฟีเจอร์ความเป็นส่วนตัวที่ติดตั้งในตัว ฟีเจอร์ด้านความปลอดภัย และ AI ที่มีความรับผิดชอบ

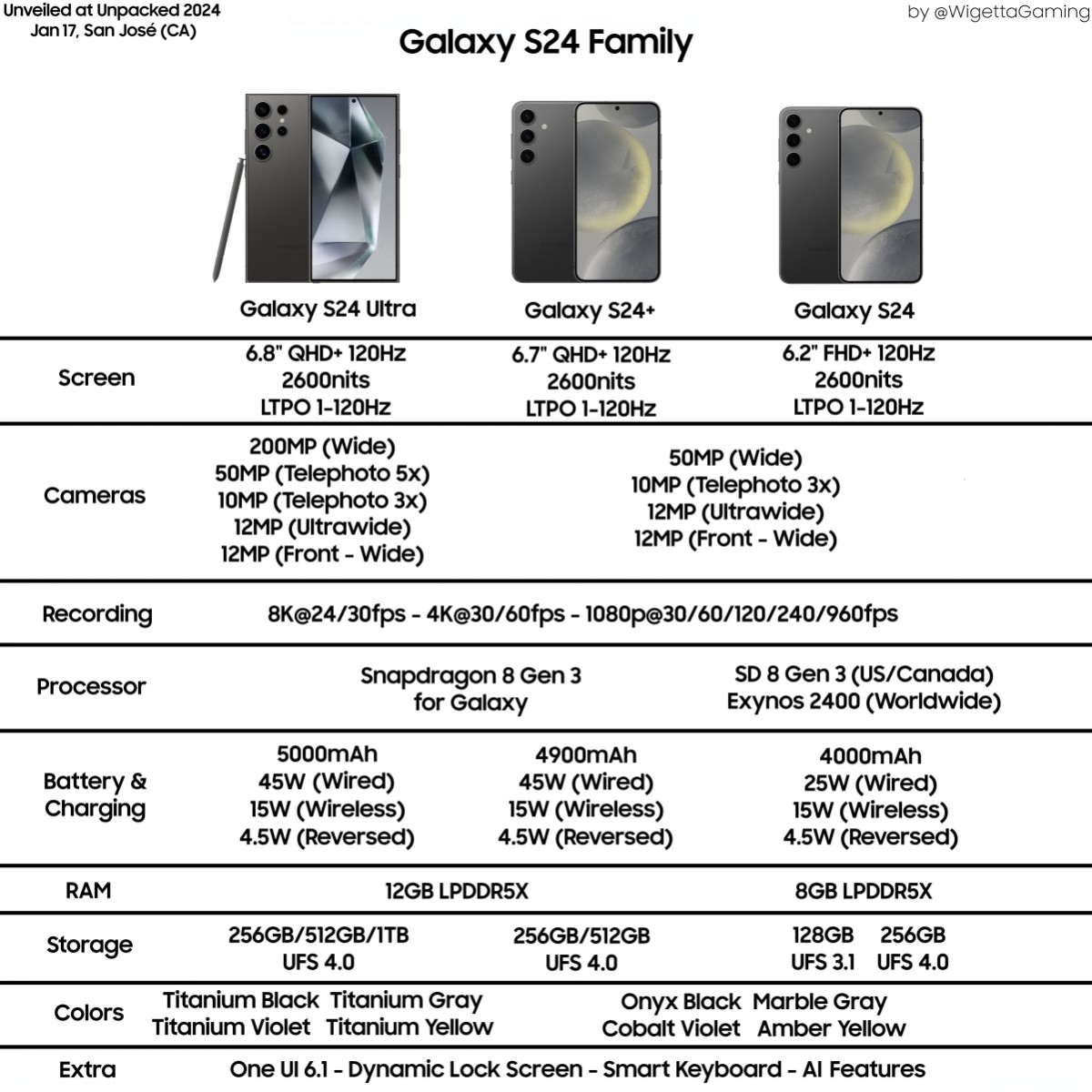

ยกระดับ AI-optimized infrastructure portfolio ของ Google Cloud

ความสามารถและแอปพลิเคชันที่ทำให้ gen AI เป็นนวัตกรรมที่ปฏิวัติวงการธุรกิจไปทั่วโลกนั้น จำเป็นต้องมีโครงสร้างพื้นฐานที่ละเอียด ซับซ้อนและมีความสามารถมากที่สุด ซึ่ง Google Cloud ลงทุนในศูนย์ข้อมูลและเครือข่ายมาเป็นเวลา 25 ปี และปัจจุบันมีเครือข่ายที่ประกอบด้วย Cloud Regions 38 แห่งทั่วโลก โดย Google Cloud ตั้งเป้าดำเนินงานโดยใช้พลังงานที่ปราศจากคาร์บอนอย่างสิ้นเชิงทุกวันตลอด 24 ชั่วโมงภายในปี 2573 ทั้งนี้ เครือข่ายของ Google Cloud ทั่วโลกประกอบด้วย ระบบคลาวด์ภูมิภาคในอินโดนีเซียและสิงคโปร์ ก่อนจะตามมาด้วยระบบคลาวด์ภูมิภาคใหม่ในมาเลเซียและไทย ดังนั้นโครงสร้างพื้นฐานที่เพิ่มประสิทธิภาพ AI ของ Google Cloud จึงเป็นตัวเลือกชั้นนำสำหรับการฝึกอบรมและการให้บริการโมเดล gen AI โดยกว่า 70% ของเหล่ายูนิคอร์น gen AI เช่น AI21, Anthropic, Cohere, Jasper, Replit, Runway, และ Typeface ได้ใช้งานและสร้างโมเดลบน Google Cloud

เพื่อช่วยให้องค์กรต่าง ๆ ในเอเชียตะวันออกเฉียงใต้เรียกใช้ AI เพื่อช่วยทำงานได้อย่างคุ้มค่าและปรับขนาดได้ตามความต้องการ Google Cloud ได้เปิดตัวการยกระดับที่สำคัญสำหรับ AI-optimized infrastructure portfolio ในชื่อ Cloud TPU v5e ที่เปิดให้ใช้งานแบบตัวอย่าง และ A3 VM with NVIDIA H100 GPU ที่เปิดให้ใช้งานได้ทั่วไปแล้ววันนี้

คำบรรยายภาพ: ภาพภายในภูมิภาค Google Cloud ที่ใช้ Cloud Tensor Processing Unit ประกอบด้วย ชิปที่สร้างขึ้นโดยเฉพาะ เครือข่ายศูนย์ข้อมูล สวิตช์วงจรออปติก ระบบระบายความร้อนด้วยน้ำ การตรวจสอบความปลอดภัยด้วยไบโอเมตริก และอื่น ๆ

Cloud TPU v5e เป็นตัวเร่ง AI ที่คุ้มค่า อเนกประสงค์ และปรับขนาดได้มากที่สุดของ Google Cloud จนถึงปัจจุบัน ซึ่งขณะนี้ลูกค้าสามารถใช้แพลตฟอร์ม Cloud Tensor Processing Unit (TPU) เพื่อดำเนินการทั้งการฝึกอบรม AI ขนาดใหญ่และการอนุมาน (inferencing) ได้ในแพลตฟอร์มเดียว โดย Cloud TPU v5e มอบประสิทธิภาพการฝึกที่สูงขึ้นถึง 2 เท่าต่อดอลลาร์ และประสิทธิภาพการอนุมานที่สูงขึ้นถึง 2.5 เท่าต่อดอลลาร์สำหรับ LLM และโมเดล gen AI ซึ่งเมื่อเปรียบเทียบกับ Cloud TPU v4 แล้ว องค์กรจำนวนมากจะสามารถฝึกฝนและปรับใช้ AI ที่ใหญ่และซับซ้อนยิ่งขึ้นได้ ในขณะนี้ Cloud TPU v5e เปิดให้ใช้งานแบบตัวอย่างในภูมิภาคคลาวด์ของ Google Cloud ในลาสเวกัสและโคลัมบัส โดยมีแผนจะขยายไปยังภูมิภาคอื่น ๆ รวมถึง Cloud Region ของสิงคโปร์ของ Google Cloud ภายในปลายปีนี้

A3 VMs ซูเปอร์คอมพิวเตอร์ที่ขับเคลื่อนโดยหน่วยประมวลผลกราฟิก H100 (GPU) ของ NVIDIA จะวางจำหน่ายทั่วไปในเดือนหน้า โดย A3 VM ช่วยให้องค์กรต่าง ๆ มีประสิทธิภาพการฝึกอบรมเร็วขึ้น 3 เท่า เมื่อเทียบกับ A2 รุ่นก่อน ซึ่งตัว A3 VM นี้สร้างขึ้นโดยมีจุดประสงค์เพื่อฝึกฝนและให้บริการทำงาน LLM และ gen AI ที่มีความต้องการสูงเป็นพิเศษ โดยบนเวทีที่งาน Google Cloud Next '23 บริษัท Google Cloud และ NVIDIA ยังได้ประกาศการขยายความร่วมมือของสองบริษัท เพื่อช่วยให้องค์กรใช้เทคโนโลยี NVIDIA ได้ในแบบเดียวกับที่ Google DeepMind และทีมวิจัยของ Google ใช้งานในช่วงสองปีที่ผ่านมา

Google Cloud ยังได้ประกาศความก้าวหน้าด้านโครงสร้างพื้นฐานที่สำคัญอื่น ๆ ดังนี้:

- Google Kubernetes Engine (GKE) Enterprise: ช่วยให้สามารถปรับขนาดคลัสเตอร์แนวนอนหลาย ๆ อันที่จำเป็นสำหรับปริมาณงาน AI และ Machine Learning (ML) ที่องค์กรต้องการมากที่สุด ขณะนี้ลูกค้าสามารถปรับปรุงประสิทธิภาพการพัฒนา AI ได้โดยใช้ประโยชน์จาก GKE เพื่อจัดการปริมาณงาน AI ขนาดใหญ่บน Cloud TPU v5e นอกจากนี้ องค์กรยังสามารถใช้ GKE สำหรับ A3 VM with NVIDIA H100 GPU ได้โดยทั่วไปแล้ววันนี้

- Cross-Cloud Network: แพลตฟอร์มเครือข่ายระดับโลกที่ช่วยให้ลูกค้าเชื่อมต่อและรักษาความปลอดภัยของแอปพลิเคชันระหว่างบนคลาวด์และภายในองค์กร โดยเครือข่ายข้ามคลาวด์นี้เป็นระบบเปิดและปรับปริมาณงานให้เหมาะสมได้ ซึ่งเป็นสิ่งสำคัญสำหรับการทำงานแบบครอบคลุมทุกขั้นตอน (end-to-end performance) จากการที่องค์กรต่าง ๆ นำ gen AI มาใช้ และเสนอการรักษาความปลอดภัยที่ขับเคลื่อนด้วย ML เพื่อส่งมอบความปลอดภัยแบบไร้ขอบเขต (zero trust)

- เครื่องมือ AI ใหม่สำหรับ Google Distributed Cloud (GDC): GDC ได้รับการออกแบบมาเพื่อตอบสนองความต้องการเฉพาะขององค์กรที่ต้องการเรียกใช้ปริมาณงานที่ edge หรือในศูนย์ข้อมูลของตน พอร์ตโฟลิโอของ GDC จะนำ AI ไปสู่ edge ด้วยการบูรณาการ Vertex AI และเครื่องมือการจัดการใหม่ของ AlloyDB Omni บน GDC Hosted

Mark Lohmeyer รองประธานและผู้จัดการทั่วไปฝ่ายโครงสร้างพื้นฐานด้านคอมพิวเตอร์และ ML ของ Google Cloud กล่าวว่า "เป็นเวลากว่าสองทศวรรษแล้วที่ Google ได้สร้างความสามารถด้าน AI ชั้นนำในอุตสาหกรรม ตั้งแต่การสร้างสถาปัตยกรรม Transformer ของ Google ที่ทำให้ gen AI เป็นจริงได้ ไปจนถึงโครงสร้าง AI-optimized ที่เราสร้างขึ้นเพื่อเพิ่มประสิทธิภาพที่จำเป็นสำหรับผลิตภัณฑ์ของ Google เช่น YouTube, Gmail, Google Maps, Google Play และ Android ที่ให้บริการแก่ผู้ใช้หลายพันล้านคนทั่วโลก และเรารู้สึกตื่นเต้นที่จะนำนวัตกรรมและการวิจัยนานหลายทศวรรษมาสู่ลูกค้าของ Google Cloud และตอบสนองความต้องการในการเปลี่ยนแปลง AI โดยครั้งนี้เรานำเสนอโซลูชันที่สมบูรณ์สำหรับ AI ตั้งแต่โครงสร้างพื้นฐานการประมวลผลที่ปรับให้เหมาะสมสำหรับ AI ไปจนถึงซอฟต์แวร์และบริการแบบ end-to-end ที่สนับสนุนวงจรการใช้งานเต็มรูปแบบของการฝึกอบรมโมเดล การปรับแต่ง และการให้บริการในระดับโลก”

ขยายการพัฒนา gen AI ที่พร้อมใช้ในองค์กรด้วยโมเดลและเครื่องมือใหม่ ๆ บน Vertex AI

คำบรรยายภาพ: Sundar Pichai ซีอีโอของ Google และ Alphabet ขึ้นเวทีที่งาน Google Cloud Next '23 เพื่อแชร์วิธีที่บริษัททำให้ AI มีประโยชน์มากขึ้นสำหรับทุกคน

นอกเหนือจากโครงสร้างพื้นฐานระดับโลกแล้ว Google Cloud ยังนำเสนอ Vertex AI แพลตฟอร์ม AI แบบครอบคลุมที่ช่วยให้ลูกค้าสามารถเข้าถึง ปรับแต่ง และปรับใช้ first-party model third-party model และ open-source model รวมถึง AI แอปพลิเคชันที่ช่วยสร้างและขยายขนาดระดับองค์กรได้อีกด้วย โดยจากการเปิดตัว gen AI support on Vertex AI ทำให้ Google Cloud กำลังขยายขีดความสามารถของ Vertex AI อย่างมีนัยสำคัญ ดังนี้:

- การปรับปรุง PaLM 2: 38 ภาษา เช่น ภาษาจีนตัวย่อ จีนตัวเต็ม อินโดนีเซีย ไทย และเวียดนาม เปิดให้ใช้งานได้กับ PaLM 2 for Text and Chat ซึ่งเป็น first-party model สำหรับการสรุปและการแปลข้อความ และการรักษาการสนทนาอย่างต่อเนื่อง โดย PaLM 2 for Text and Chat สามารถเข้าถึงได้ผ่าน Model Garden ของ Vertex AI ควบคู่ไปกับความสามารถในการปรับแต่งอะแดปเตอร์ ดังนั้นองค์กรต่าง ๆ ในเอเชียตะวันออกเฉียงใต้สามารถสร้างแอปพลิเคชัน gen AI ที่ให้บริการผู้ใช้ในภาษาท้องถิ่นได้ดีขึ้น ขณะที่สามารถ grounding การตอบสนองผ่านข้อมูลองค์กรหรือคลังข้อมูลส่วนตัวขององค์กรได้เช่นกัน ทั้งนี้ Google Cloud กำลังวางแผนที่จะเปิดให้ใช้งาน PaLM 2 for Text and Chat ใน Cloud Region ของสิงคโปร์ในปลายปีนี้ เพื่อรองรับการแชทคำถาม-คำตอบที่ยาวขึ้น รวมถึงสรุปและวิเคราะห์เอกสารขนาดใหญ่ เช่น เอกสารวิจัย หนังสือ และบทสรุปทางกฎหมาย ขณะนี้ PaLM 2 for Text and Chat จะรองรับหน้าต่างบริบท 32,000 โทเค็น (หรือ เพียงพอที่จะรวมเอกสาร 85 หน้าในพรอมต์)

- การปรับปรุง Codey: ปรับปรุงคุณภาพของ Codey ซึ่งเป็น first-party model ของ Google Cloud สำหรับการสร้างและแก้ไขโค้ดซอฟต์แวร์ มากถึง 25% ในภาษาหลักที่รองรับสำหรับการสร้างโค้ดและการแชทด้วยโค้ด ทำให้องค์กรต่าง ๆ สามารถเข้าถึง Codey ผ่านทาง Model Garden ของ Vertex AI ควบคู่ไปกับความสามารถในการปรับแต่งอะแดปเตอร์ โดย Google Cloud กำลังวางแผนที่จะเปิดให้ใช้งาน Codey ใน Cloud Region ของสิงคโปร์ในปลายปีนี้

- การปรับปรุง Imagen: Google Cloud เปิดตัว Style Tuning สำหรับ Imagen ซึ่งเป็นความสามารถใหม่ที่ช่วยให้องค์กรต่าง ๆ จัดแนวรูปภาพให้สอดคล้องกับหลักเกณฑ์ของแบรนด์ด้วยรูปภาพสูงสุดถึง 10 ภาพ โดย Imagen เป็น first-party model ของ Google Cloud สำหรับการสร้างรูปภาพระดับสตูดิโอจากคำอธิบายข้อความ ซึ่งองค์กรต่าง ๆ สามารถเข้าถึง Imagen ผ่านทาง Model Garden ของ Vertex AI นอกจากนี้ Google Cloud ยังได้เปิดตัวลายน้ำดิจิทัลบน Vertex AI เพื่อให้องค์กรต่าง ๆ สามารถตรวจสอบรูปภาพที่สร้างโดย AI จาก Imagen ซึ่งเปิดให้ทดลองใช้ได้แล้ววันนี้ ความพร้อมใช้งานของลายน้ำดิจิทัลแบบทดลองบน Vertex AI ทำให้ Google Cloud เป็นผู้ให้บริการคลาวด์ระดับไฮเปอร์สเกลรายแรกที่เปิดใช้งานการสร้างลายน้ำที่มองไม่เห็นและป้องกันการงัดแงะในรูปภาพที่สร้างโดย AI ทั้งนี้เทคโนโลยีดังกล่าวขับเคลื่อนโดย Google DeepMind SynthID ซึ่งเป็นเทคโนโลยีล้ำสมัยที่ฝังลายน้ำดิจิทัลลงในภาพพิกเซลโดยตรง ทำให้มองไม่เห็นด้วยตามนุษย์ และยากต่อการดัดแปลงโดยไม่ทำให้ภาพเสียหาย

- โมเดลใหม่: Llama 2 และ Code Llama จาก Meta โมเดลโอเพ่นซอร์สยอดนิยม Falcon LLM จากสถาบันนวัตกรรมเทคโนโลยี พร้อมใช้งานแล้วบน Model Garden ของ Vertex AI นอกจากนี้ Google Cloud ยังได้ประกาศล่วงหน้าถึงความพร้อมใช้งานของ Claude 2 จาก Anthropic บน Model Garden ของ Vertex AI โดย Google Cloud จะเป็นผู้ให้บริการระบบคลาวด์เพียงรายเดียวที่นำเสนอทั้งการปรับแต่งอะแดปเตอร์และการเรียนรู้การเสริมแรงจากคำติชมของมนุษย์ (RLHF) สำหรับ Llama 2

- ส่วนขยาย Vertex AI: นักพัฒนาสามารถเข้าถึง สร้าง และจัดการส่วนขยายที่ส่งข้อมูลแบบเรียลไทม์ บูรณาการข้อมูลบริษัท และดำเนินการในนามของผู้ใช้

- Vertex AI Search and Conversation: ช่วยให้องค์กรต่าง ๆ สามารถสร้างแอปพลิเคชันการค้นหาและแชทขั้นสูงโดยใช้ข้อมูลของตนได้ในเวลาเพียงไม่กี่นาทีด้วยการเขียนโค้ดเพียงเล็กน้อย อีกทั้งยังมีการจัดการระดับองค์กรและการรักษาความปลอดภัยในตัวอีกด้วย ซึึ่งเครื่องมือเหล่านี้เปิดใช้งานทั่วไปแล้ว

- Grounding: Google Cloud ประกาศบริการการรองรับระดับองค์กรที่ทำงานผ่าน Vertex AL Search และ Conversation รวมถึงโมเดลพื้นฐานบน Model Garden ของ Vertex AI ซึ่งจะช่วยให้องค์กรต่าง ๆ สามารถรองรับข้อมูลองค์กรของตนเองเพื่อให้การตอบสนองที่แม่นยำยิ่งขึ้น Google Cloud ยังทำงานร่วมกับลูกค้ากลุ่มแรก ๆ บางรายเพื่อทดสอบ grounding ด้วยเทคโนโลยีที่ขับเคลื่อน Google Search

Google ประเมินผลโมเดลอย่างเข้มงวดและแม่นยำเพื่อให้แน่ใจว่าเป็นไปตามหลักการ Responsible AI Principles ของบริษัท เมื่อใช้ Vertex AI ลูกค้าจะสามารถควบคุมข้อมูลของตนได้อย่างสมบูรณ์โดยไม่จำเป็นต้องออกจากระบบเช่าคลาวด์ของลูกค้า รวมถึงลูกค้าจะได้รับการเข้ารหัสทั้งระหว่างรับส่งและพักอยู่ และไม่มีการแชร์หรือใช้เพื่อทดสอบโมเดลของ Google อย่างแน่นอน

Thomas Kurian ซีอีโอของ Google Cloud กล่าวว่า “การควบคุมข้อมูล เป็นสิ่งที่สำคัญพอ ๆ กับการค้นหาและฝึกใช้โมเดลที่เหมาะสมต่อการทำงาน โดยตั้งแต่เริ่มต้น เราได้ออกแบบ Vertex AI เพื่อให้คุณสามารถควบคุมและแยกข้อมูล โค้ด และทรัพย์สินทางปัญญาได้อย่างสมบูรณ์โดยที่ข้อมูลไม่เกิดการรั่วไหลแม้แต่น้อย เมื่อคุณปรับแต่งและฝึกใช้โมเดลของคุณด้วย Vertex AI ที่มีเอกสารส่วนตัวและข้อมูลจากแอปพลิเคชัน SaaS ฐานข้อมูล หรือแหล่งที่มาที่เป็นกรรมสิทธิ์อื่น ๆ คุณจะไม่ได้เปิดเผยข้อมูลเหล่านั้นแก่โมเดลพื้นฐาน เพราะเราทำการ snapshot โมเดลเพื่อให้คุณสามารถฝึกและรวมโมเดลเข้าด้วยกันในการกำหนดค่าส่วนตัว ซึ่งทำให้คุณควบคุมข้อมูลของคุณได้อย่างสมบูรณ์ นอกจากนี้ พรอมต์และข้อมูลของคุณ ตลอดจนอินพุตของผู้ใช้ในระยะเวลาความเร็วในการแปรผลของแบบจําลอง จะไม่ถูกใช้เพื่อปรับปรุงโมเดลของเรา และไม่ถูกเข้าถึงจากลูกค้ารายอื่นอีกด้วย”

องค์กรต่าง ๆ ในครอบคลุมหลายอุตสาหกรรมและทั่วโลกต่างใช้ Vertex AI เพื่อสร้างและปรับใช้แอปพลิเคชัน AI ได้แก่บริษัท affable.ai, Aruna, Bank Raykat Indonesia, FOX Sports, GE Appliances, HCA Healthcare, HSBC, Jiva, Kasikorn Business-Technology Group Labs, KoinWorks, The Estée Lauder Companies, รัฐบาลสิงคโปร์, Mayo Clinic, Priceline, Shopify, Wendy’s และอีกมากมาย

“นับตั้งแต่ประกาศ gen AI support on Vertex AI เมื่อไม่ถึงหกเดือนที่ผ่านมา เรารู้สึกตื่นเต้นและยินดีเป็นอย่างยิ่งที่ได้เห็นการใช้งานอย่างสร้างสรรค์จากลูกค้าทุกประเภท ตั้งแต่ระดับองค์กร เช่น GE Appliances ที่ได้ใช้งานแอปสำหรับผู้บริโภค SmartHQ เพื่อมอบความสามารถในการสร้างสูตรอาหารแบบหลากหลายที่อิงจากอาหารในครัว ไปจนถึงสตาร์ทอัพยูนิคอร์นอย่าง Typeface ที่ช่วยให้องค์กรต่าง ๆ ใช้ประโยชน์จาก AI ในการเล่าเรื่องราวที่น่าสนใจขององค์กร เป็นต้น ซึ่งทั้งหมดนี้เราเห็นความต้องการที่เพิ่มขึ้นเรื่อย ๆ โดยจำนวนบัญชีลูกค้า Vertex AI เพิ่มขึ้นกว่า 15 เท่าในไตรมาสที่แล้ว” Kurian กล่าวปิดท้าย

คุณกำลังดู: Google Cloud Next ‘23 เปิดตัวโครงสร้างพื้นฐานและโมเดล AI

หมวดหมู่: เทคโนโลยีใหม่